ChatGPT橫空出世,一夕爆紅,各國大型語言模型軍備戰正式開打,Google、百度、阿里等企業紛紛公開自家版本的類似模型,並可用在較為複雜的文字工作。

但主要研究領域包括機器學習、深度學習、語意理解、語音辨識的台灣大學電機工程學系副教授李宏毅指出,AI不能只是會讀文字或是語音辨識而已,而是要知道語音所有的面向。

「AI要能夠辨識這個人講話中的情緒,然後能夠根據不同的情緒,而有不一樣的回答。」李宏毅說:「語音是人與人之間最自然的溝通方式,小孩可以在幾乎沒有標註資料的情況下,就能夠學會人類語言,機器應該也能做到同樣的事情。」

語音AI開發困難度遠超於文字

但語音AI的複雜程度跟文字不是同一個量級。李宏毅指出,因為語音跟文字不是一對一的關係,不能只是轉成文字,語音裡面還有很多文字沒有辦法表達的品質,包括語氣、誰在說話、說話的人有什麼樣的背景等雜訊,甚至說話的人的健康狀況、年齡等,也都會反映在語音裡面。

以Google在2018年提出的預訓練語言模型BERT(Bidirectional Encoder Representations from Transformers)為例, Google只是讓模型自己去閱讀大量的文字(約33億字的英文小說及英文維基百科文本),然後用來解決不同文字類型的各種任務,用的運算資源就已經非常的驚人,何況是複雜度更高的預訓練語音模型!

「舉例來說,BERT是用填空的方式,讓機器學習把正確的文字填進去。但在語音上就沒有辦法直接套用類似的方式。」李宏毅說:「因為文字的單位很容易區分,以中文為例,一個方塊字就是一個單位。但在語音裡面,它就是一堆聲音訊號,你根本不知道哪裡算是一個單位。」

此外,相較於文字,聲音訊號的序列長非常多,也導致處理語音AI需要更為龐大的運算資源。「比如說一篇100字的文章,就是長度為100的序列。」李宏毅說:「一般人大約一分鐘可以講100字,語音通常是以0.01秒為單位,每0.01秒用一個向量來表示,所以一分鐘的語音訊號,需要用 6,000 個向量來表示。」

台智雲提供算力助台大突破瓶頸

當資料量愈大,需要的運算資源也要更多,但台大當時的實驗室運算資源很有限,只能用1000個小時的訓練資料,即使如此,訓練一個模型可能還是要一周的時間,對台大團隊而言,已經是非常大的負擔。

但李宏毅也指出,只要有更多的運算資源,台大團隊很可能就可以有更好的成果。為了鼓勵更多人來開發,李宏毅決定在2020年起舉辦SUPERB(Speech processing Universal PERformance Benchmark)挑戰賽,讓參賽者上傳訓練好的基石模型所包裝的系統,然後由比賽主辦方在這個系統上面,再去加額外的APP,來評估這個系統及模型的好壞,但這種做法非常耗費運算資源,而且要由主辦方提供,絕對不是一般學術研究機構所能夠負擔。

所幸台智雲在此時伸出援手,不但成功的支援SUPERB比賽的進行,包括Meta及微軟等公司,都有使用這個比賽的資料,代表SUPERB已經是現在全世界公認自督導式學習的評估標準。

JSALT大放異采

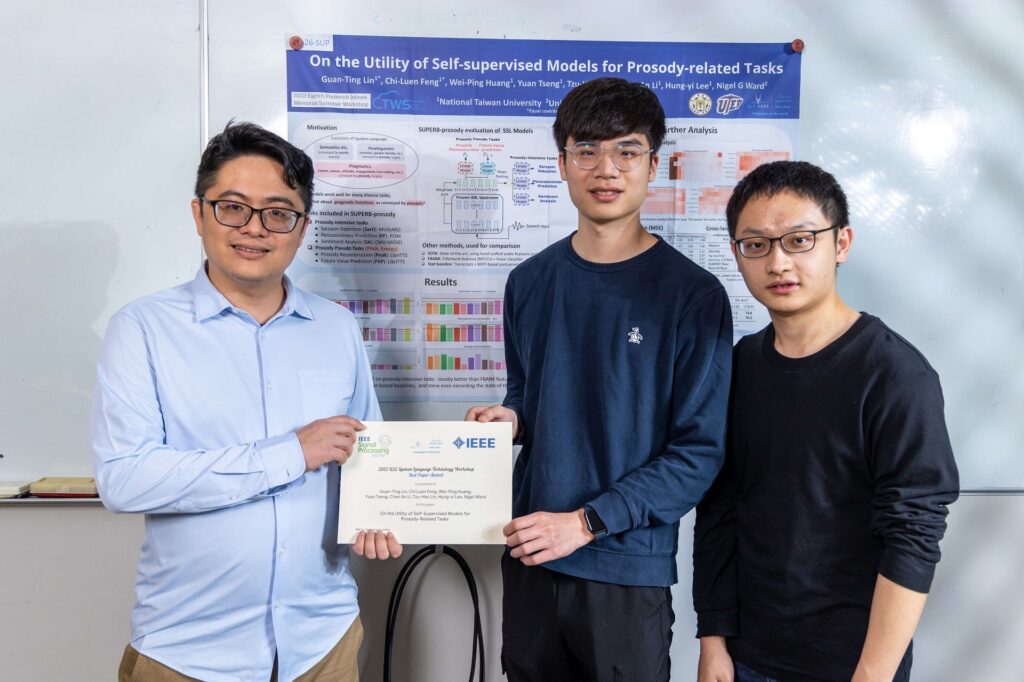

台大團隊緊接著就是參加語音AI領域研究成果最重要的發布場所之一的JSALT(Eighth Frederick Jelinek Memorial Summer Workshop),一樣是由台智雲提供運算資源,讓台大團隊能夠與世界一流的語音AI研發團隊一較高下。

李宏毅回憶當時跟台大團隊一起競爭的團隊中,甚至有來自歐盟支持的團隊,而且還從法國政府拿到免費且沒有上限的運算資源。但台大團隊在台智雲的鼎力協助下,研究成果依然能夠脫穎而出。

「歐盟團隊說他們用了10萬個GPU Hour時,其實台大團隊也是用了10萬個GPU Hour。可見若不是台智雲,我們就無法擁有跟歐盟團隊同等級的運算資源。」李宏毅說:「而且在研討會現場,不能說只是理論上可行,還要展現出成果,我們就在約翰霍普金斯大學遠端使用台智雲,最終在期末的成果展示上才能夠說服來自全世界的近百位學者,我們的構想不但有被完成,而且做到的就是當時世界上最好的結果。」

台大團隊成員之一,目前就讀台大電信所博士班的林冠廷指出,運用台智雲資源可以容納的資料跟運算,是台大實驗室的數倍以上,有了台智雲比較高階的運算資源之後,環境配置都會更大,一次可以要8張、16張卡,許多大的實驗都可以放開來執行,也是可以達到不錯的效果。

另一位成員,即將前往美國德州大學奧斯汀分校研究所就讀的施貽仁也指出,運算資源換成台智雲之後,不只是可以用的GPU數量變多,儲存空間也比較大,最多可以建立十幾個模型,可以更快的去嘗試各種想法,就可以再優化進步。

施貽仁進一步指出,台智雲包括儲存空間的使用及計費也都比較有彈性,如果模型沒那麼大,就不需要開這麼多的資源,可以根據使用需求有效控制預算。

正視運算資源的重要性

「我們在做研究時,一旦被手上的運算資源綁住,就不敢做更大的事情。」李宏毅說:「模型及資料量都要大到一定的程度,AI在接受訓練時,才會產生頓悟的現象,如果沒有足夠的運算資源,AI就會學很久很久。」

台智雲提供的跨節點GPU使用服務,此時就顯得格外重要。「假設有人要跑200億個參數的模型,系統跑不動時,就需要跨機器。」李宏毅說:「如果不能跨節點,就只能用時間來換取GPU,但這樣就浪費時間,開發時間也是一種成本,甚至也是一種比賽。」

李宏毅呼籲各界,要更加正視運算資源的重要性。「運算資源並不是買1萬張GPU就可以用來訓練AI。」李宏毅說:「1萬張GPU要怎麼串起來,全部都可以運作;如果某一張壞了,資料要怎麼處理,才不會讓這個模型壞掉,這些都需要很深的技術,需要大家更加重視。」

「在AI 2.0的時代,各行各業都會想要自己擁有一個類似的模型,但大語言模型是無法自己跑得起來,這時候就可以借助台智雲的服務,去做更多的事情。」李宏毅說。

![]() 高安全、可落地的「企業生成式 AI 解決方案」: https://tws.twcc.ai/afs/

高安全、可落地的「企業生成式 AI 解決方案」: https://tws.twcc.ai/afs/